要点:

- 人工智能企业高管们警示决策者,人工智能风险不亚于大流行病和核战风险。

- 最近的发展引发担忧:人工智能技术或导致“智能机器”自行思考。

- 预计美国和欧盟国家将与行业领导者讨论人工智能风险问题。

包括OpenAI首席执行官山姆·奥尔特曼(Sam Altman)在内的顶级人工智能高管,与专家和教授们一起提出了“人工智能导致的灭绝风险”,并警示决策者,人工智能风险不亚于大流行病和核战风险。

“减轻人工智能导致灭绝的风险应与其他社会规模的风险(如大流行病和核战争)一样,成为全球优先事项。” 有超过350名签署者在非营利组织人工智能安全中心(Centre for AI Safety)发布的一封信中写道。

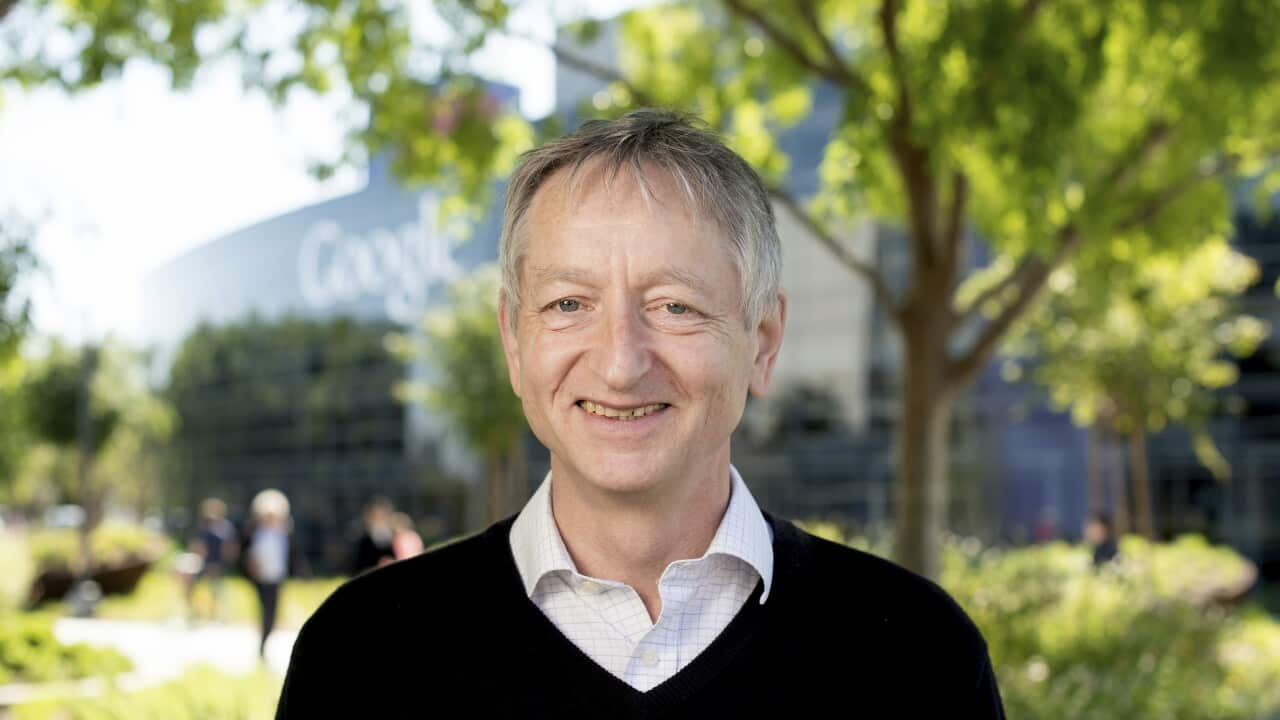

除了奥尔特曼,签署该文件的企业高管还包括DeepMind和Anthropic等人工智能公司的首席执行官,微软和谷歌的高管,以及被誉为“人工智能教父”的杰弗里·辛顿(Geoffrey Hinton)和约书亚·本吉奥(Yoshua Bengio)—— 他们是2018年图灵奖的获得者。此外,来自哈佛大学到中国清华大学等机构的教授们也参与了签署。

人工智能安全中心的声明特别指出来自Meta公司的第三位“人工智能教父” 扬·勒康(Yann LeCun)未签署该信件。

人工智能安全中心主任 丹 · 亨德里克斯(Dan Hendrycks)表示:“我们向许多Meta员工发出了签署邀请。”

Meta尚未立即回应置评请求。

这封信与美国-欧盟贸易和技术理事会(United States-European Union Trade and Technology Council)在瑞典召开的会议同时发布,会议上政界人士预计将讨论对人工智能的监管。

人工智能风险于今年4月被埃隆·马斯克(Elon Musk)和一群人工智能专家和行业高管首次提出。

“我们已向(马斯克)发出邀请,希望他本周能签署。” 亨德里克斯表示。

人工智能最新开发创造了一些工具,支持者表示这些工具可以应用于医学诊断以及编写法律备忘录等领域,但这也引发了各界对该技术可能导致侵犯隐私、助长虚假信息传播和智能机器自主思考问题的担忧。

该警告被提出的2个月前,非营利组织未来生命研究所(Future of Life Institute)发布类似了公开信。该信件由马斯克和其他数百人签署,要求紧急暂停先进的人工智能研究,理由是对人类存在风险。

“我们的信让暂停成为主流,现在让灭绝成为主流。” 未来生命研究所主席马克斯·泰格马克(Max Tegmark)表示,他也在最新的信件中签署了名字。

“现在,一个建设性的公开对话终于可以开始了。”

人工智能先驱者辛顿早些时候告诉路透社,人工智能可能对人类构成比气候变化更 “紧迫”的威胁。

上周,OpenAI的首席执行官奥尔特曼将欧盟人工智能(EU AI)称为过度监管,并威胁要离开欧洲。欧盟人工智能是为监管人工智能制定政策的首次努力。

READ MORE

人工智能“教父”退出谷歌 并对世界发出警告

在遭到政界人士的批评后,奥尔特曼在几天内改变了立场。

奥尔特曼在ChatGPT聊天机器人风靡全球后,他成为了人工智能的代表人物。

欧盟委员会(European Commission)主席冯德莱恩(Ursula von der Leyen)将于周四会见奥尔特曼,欧盟产业主管蒂埃里·布雷顿( Thierry Breton)将于下个月在旧金山与他会面。

欢迎下载应用程序SBS Audio,关注Mandarin。您也可以通过苹果播客、谷歌播客、Spotify等播客平台随时收听和下载SBS普通话音频故事。